苹果宣布能够检测用户图书馆中虐待儿童的照片

苹果宣布能够检测用户图书馆中虐待儿童的照片

苹果为其设备宣布新功能,以帮助虐待儿童。

苹果继续在安全方面工作,并为虐待儿童方面的物质检测。

苹果反对虐待儿童

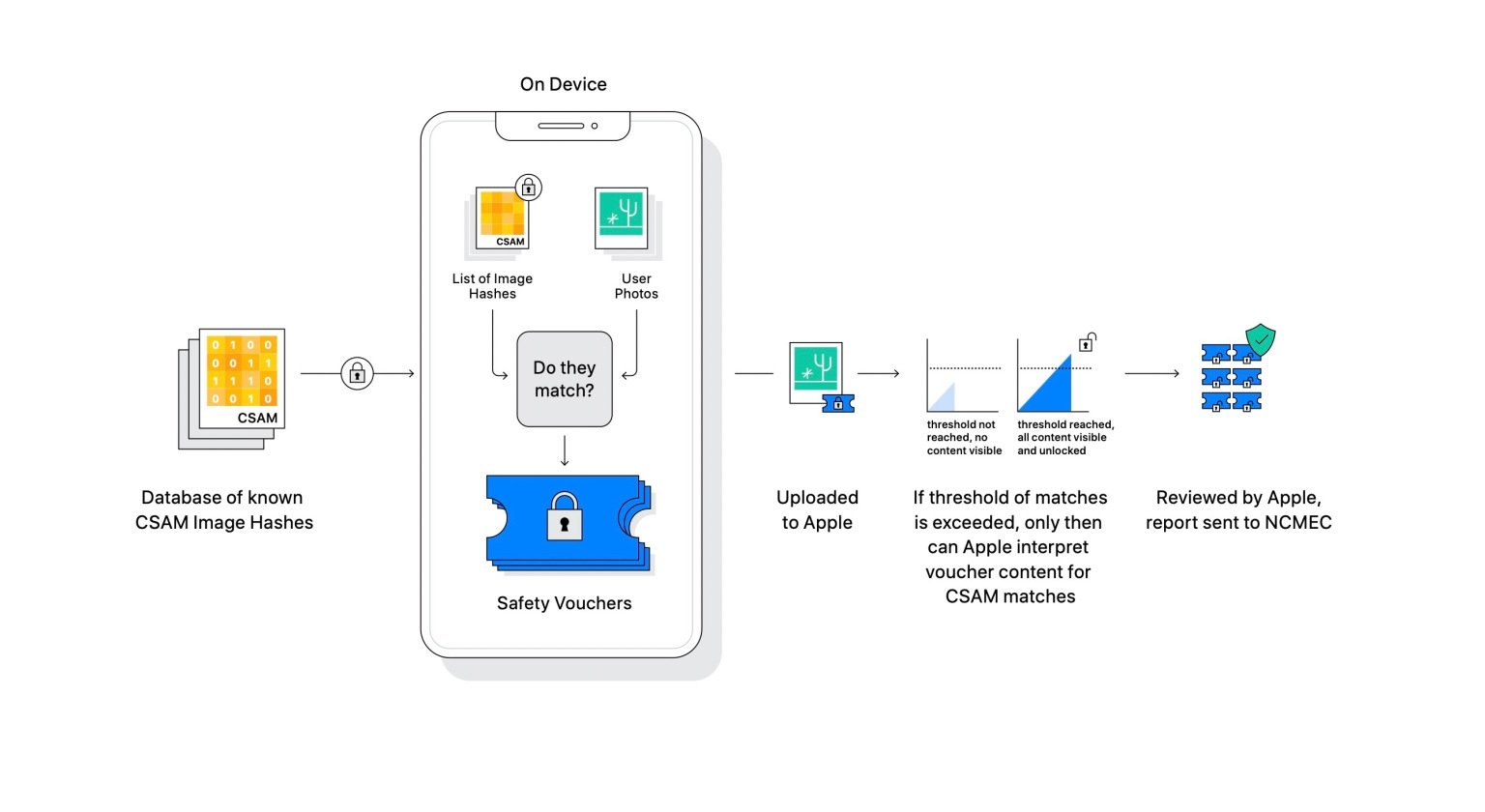

根据报告的报告,苹果会宣布带有哈希算法的新工具用于摄影与虐待儿童有关的内容。所有这些一个新系统这将安装在用户的设备上,并将图像与非法材料进行比较以查找巧合。

这个新系统将通过不违反公司当前使用的隐私规则的数字足迹来使用,这将干预将文件上传到iCloud照片的避免传播和保护不当材料。

现在是现实。正式宣布了苹果公司一项新倡议在iPhone,iPad和Mac上保护儿童。用短语:“保护儿童是重要的责任”。苹果为这一新的安全进步宣布了3个新颖性。

CSAM检测

苹果带有CSAM,是指显示涉及孩子的性明确活动的内容。为此,他已经实施了一种新的识别方法对于用户的内容,以通过上面提到的哈希过程找到巧合,因此能够向国家缺失和被剥削的儿童报告CSAM案例。

“在将图像存储在iCloud照片中之前,该图像在该图像上进行了比较过程,并使用一组已知的CSAM哈希集合进行了比较。这个巧合的过程是由一种称为私人集体交叉路口的加密技术驱动的,该技术决定是否存在巧合而没有揭示结果。私有集合(PSI)的交集使Apple可以知道图像哈希是否与已知的CSAM图像哈希相吻合,而无需了解任何不合时宜的图像哈希。 PSI还阻止用户知道是否有巧合。

因此没有错误,苹果利用一种名为Threshold的新技术,哪个过滤和确保检测是正确的,并且无法创建对CSAM的错误发现。根据Apple数据,该系统的错误率每年的错误率小于10亿分之一。

检测是通过信息过滤器和CSAM数据库和用户库的图像进行比较进行的。

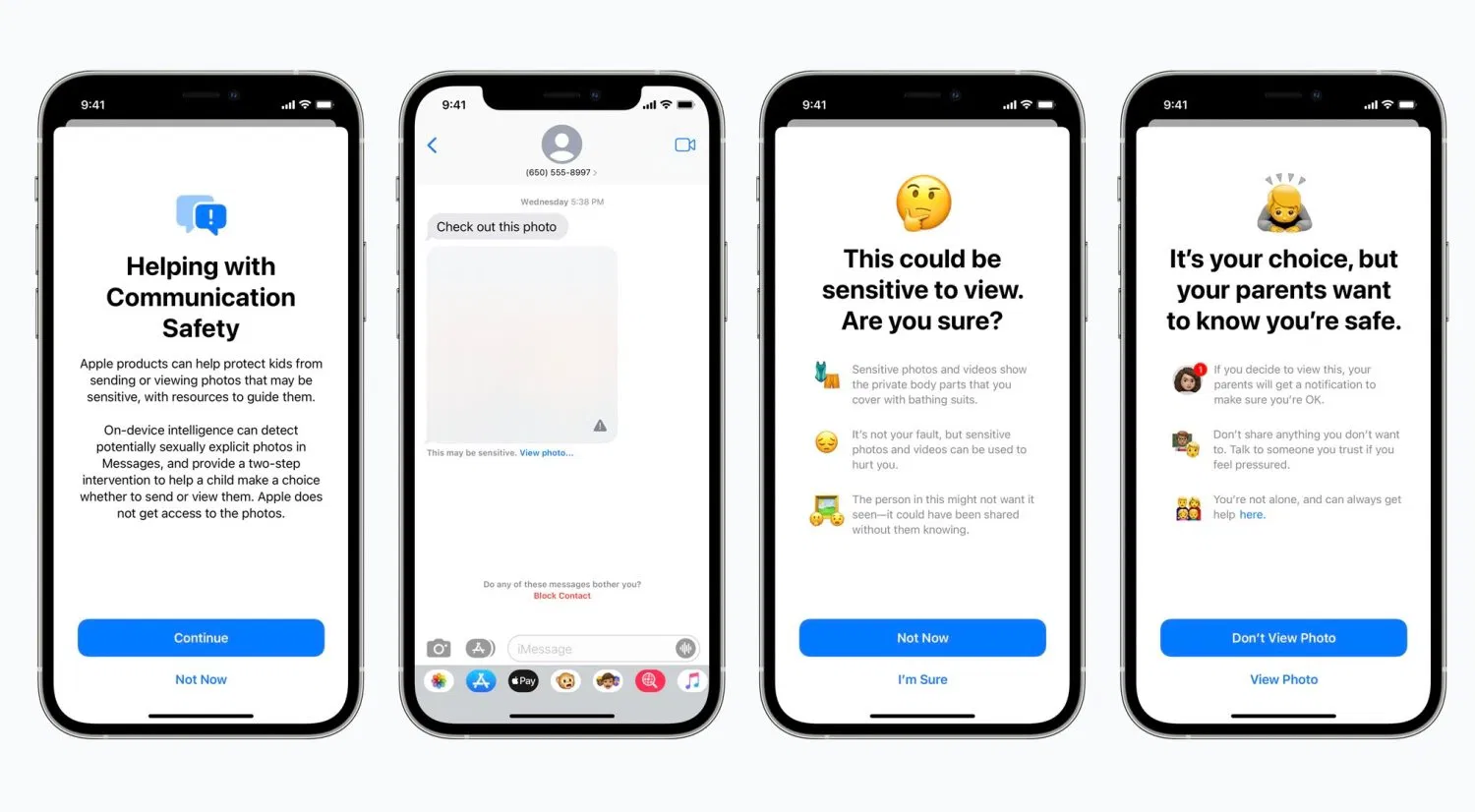

消息

有关未成年人安全的最重要的新颖性之一,带有消息。现在有通过iCloud链接到家庭的苹果设备他们将在收到或发送可以明确的图像后在消息中发出警告通知。

没错,每个人都会收到一个可以敏感的图像,会显得模糊,并且该应用将立即发送警告通知。在此警告中,将宣布孩子为何不尽iCloud的父亲将收到通知“确保你很好。”

当最小的试图发送一张被认为是性别明确的照片时,也会发生同样的情况。

苹果提到系统开始自动学习,这有助于确定敏感内容,而无需打破服务的结束 - 末端加密协议对话将保持私密,但对孩子更安全。

父母可能会通过iCloud的家人对孩子有更多的控制权。

搜索和Siri

最后,Siri的功能并搜索Apple设备他们已经改编了就虐待儿童的问题提供帮助。

“苹果还通过提供其他资源来帮助孩子和父母在网上待在网上并获得不安全情况的帮助,从而扩大了Siri的迎新。例如,问Siri的用户如何报告儿童性虐待或剥削儿童的用户将针对在何处以及如何提出投诉的资源。

当用户搜索与CSAM相关的咨询时,Siri和Search也正在更新以进行干预。这些干预措施将向用户解释,对这个问题的兴趣是有害和有问题的,并将提供合作伙伴的资源以在此主题上获得帮助。

Siri和搜索功能还将提供有关虐待儿童的帮助和信息。

这些新颖性将在iOS 15,iPados 15和Macos Monterey的更新中实施,并将在美国开始,并将扩展尽快地到其他地区。

毫无疑问,这是一步对于社会福利,对于使用设备的未成年人的控制和护理,以及可能影响苹果成功的事物今天赚取最多钱的第六家公司。

你可以跟随ipadi在Facebook,,,,WhatsApp,,,,Twitter(x)咨询我们的电报频道了解最新技术新闻。

![修复卡在恢复模式的iPhone [支持iOS 18]](https://jjgvkw.com/tech/ella/wp-content/uploads/cache/2025/04/1745493272_798_gude-img-2.png)